La Google Hacking Database (GHDB) es, en esencia, una biblioteca pública de consultas de búsqueda avanzadas, más conocidas como Google Dorks. Estas consultas están diseñadas para destapar información sensible que ha sido expuesta en internet por accidente. No se trata de una herramienta para atacar a Google, sino de un recurso clave para que los profesionales de la seguridad encuentren brechas en sus propios sistemas antes de que lo haga un atacante. Este guía te mostrará, con un caso práctico, cómo usarla para proteger tu negocio.

El caso: una tienda online expone datos de clientes por un backup olvidado

La teoría está muy bien, pero es en la práctica donde las cosas realmente encajan. Vamos a ponernos en la piel de un auditor de seguridad para simular cómo usaría la Google Hacking Database para detectar una vulnerabilidad bastante crítica: una base de datos SQL de una tienda online ficticia, totalmente expuesta en internet.

Y no, no es un escenario de película. Un simple descuido, como dejar un archivo de respaldo en una carpeta pública, puede abrir una brecha de seguridad de dimensiones catastróficas. Veamos paso a paso cómo se detecta, se soluciona y, lo más importante, cómo se evita que vuelva a ocurrir.

Resumen del caso: un backup a la vista de todos

Una pequeña tienda online, "GadgetsExpress.com", realiza backups diarios de su base de datos para protegerse ante fallos. Un día, durante una actualización de emergencia, un desarrollador deja un archivo de respaldo llamado db_backup_2024.sql en un directorio público del servidor (/backups). Este archivo contiene tablas con datos personales de clientes, credenciales de acceso hasheadas y detalles de pedidos. El rastreador de Google indexa este archivo, dejándolo accesible a cualquiera que sepa cómo buscarlo.

La exposición accidental de datos es un vector de ataque sorprendentemente común. En España, el fenómeno del Google Hacking está directamente relacionado con el aumento de ciberataques que explotan vulnerabilidades descubiertas a través de búsquedas avanzadas. Para más detalles sobre las tendencias actuales, puedes consultar el análisis completo de Channel Partner.

Aquí tienes una captura de cómo se ve la interfaz de la Google Hacking Database en Exploit-DB, donde la comunidad comparte sus hallazgos.

Como puedes ver, cada entrada incluye la consulta, la categoría de la vulnerabilidad que destapa y la fecha en que fue descubierta. Esto crea un archivo histórico y práctico de fallos de seguridad muy comunes.

Usar la GHDB de forma proactiva es una práctica fundamental en cualquier auditoría de seguridad o prueba de intrusión. De hecho, es uno de los primeros pasos en la fase de reconocimiento de cualquier evaluación de seguridad ofensiva. Puedes aprender más sobre esto en nuestra guía detallada sobre qué es el pentesting. Permite a los equipos de seguridad pensar como un atacante y encontrar sus propias debilidades antes de que sean explotadas, transformando una herramienta de ataque en un poderoso escudo defensivo.

Análisis técnico paso a paso: cómo se explotó la vulnerabilidad

Un auditor de seguridad (o un atacante) no necesita herramientas complejas para encontrar este tipo de fugas. Solo necesita entender el lenguaje de Google y la estructura de los Google Dorks.

La consulta delatora: el Google Dork que lo encuentra todo

Para dar con este archivo expuesto, se utilizaría un Google Dork que combina varios operadores para ser lo más específico posible. La clave es filtrar el ruido y encontrar únicamente lo que interesa: copias de seguridad de bases de datos que, con alta probabilidad, pertenezcan a una tienda online.

La consulta podría ser algo así:

filetype:sql inurl:"/backup/" "CREATE TABLE clientes"

Vamos a desmontar este dork:

filetype:sql: Le dice a Google que solo queremos archivos con la extensión.sql. Ni más ni menos.inurl:"/backup/": Filtra los resultados para que solo muestre URLs que contengan la carpeta/backup/."CREATE TABLE clientes": Busca dentro del propio archivo la frase exacta "CREATE TABLE clientes", un comando SQL que delata que estamos ante una base de datos de comercio electrónico.

La combinación de estos tres elementos crea una consulta potentísima que reduce drásticamente los falsos positivos.

Un dork bien construido no es magia, es lógica pura. Cada operador actúa como un filtro que va descartando lo que no sirve, hasta dejar al descubierto la información que nunca debió ser pública.

La escalada del ataque

Una vez descargado el archivo db_backup_2024.sql, un atacante tendría acceso a:

- Datos personales de clientes: Nombres, direcciones, correos electrónicos, teléfonos.

- Credenciales de acceso: Aunque las contraseñas estén hasheadas, un atacante podría intentar romper los hashes más débiles mediante ataques de fuerza bruta offline.

- Historial de pedidos: Información sobre qué compraron los clientes y cuándo.

Con estos datos, podría lanzar ataques de phishing dirigidos, suplantar identidades o intentar usar las credenciales en otros servicios, explotando la reutilización de contraseñas.

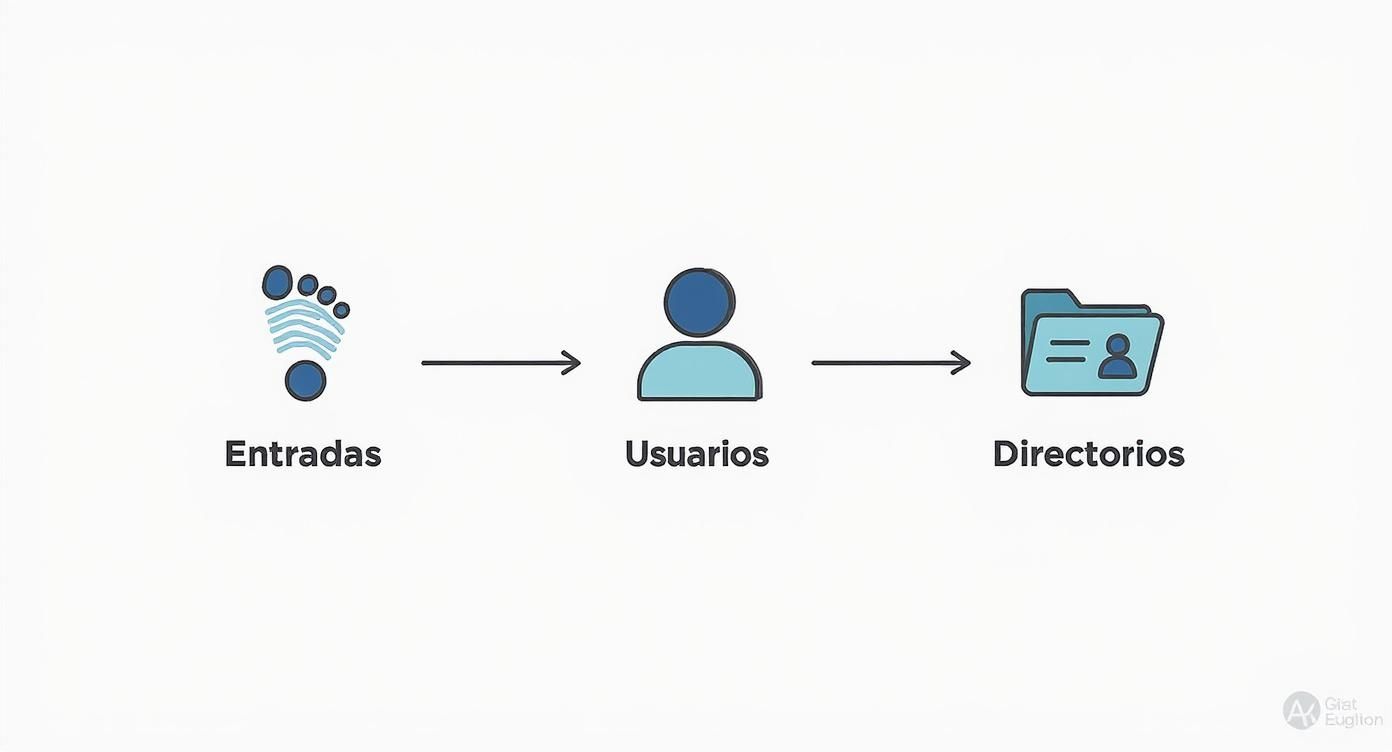

El siguiente esquema muestra cómo se pueden ir encadenando los dorks para encontrar distintos tipos de información expuesta, desde puntos de entrada hasta directorios con datos sensibles.

Como se puede ver, un atacante o un auditor puede progresar de forma lógica, empezando con búsquedas generales y afinando poco a poco hasta dar con los datos más jugosos.

Remediación inmediata: cómo cerrar la brecha de seguridad

Una vez localizado el archivo, el tiempo es oro. Las acciones para remediarlo deben ser rápidas y contundentes para minimizar el riesgo de que alguien más lo encuentre y lo explote.

- Aislar el servidor: Si se sospecha de un compromiso activo, el primer paso es aislar el servidor de la red para evitar movimientos laterales.

- Restringir el acceso al directorio: Lo siguiente es bloquear el acceso público a la carpeta

/backup/. Esto se puede hacer en segundos añadiendo un archivo.htaccessen esa carpeta con una simple línea:Deny from all. - Eliminar el archivo del servidor: Con el acceso ya bloqueado, el archivo

.sqldebe borrarse permanentemente del servidor. - Solicitar la desindexación a Google: A través de Google Search Console, se solicita que se elimine la URL del índice de búsqueda para que deje de aparecer en los resultados.

- Rotar credenciales: Se deben resetear todas las contraseñas de los clientes y credenciales de acceso a la base de datos como medida de precaución.

- Restaurar desde un backup seguro: Validar y restaurar la última copia de seguridad limpia conocida.

Con esto se corta la hemorragia de datos de inmediato. Pero el trabajo no ha terminado.

Prevención con controles concretos para que no vuelva a pasar

La prevención es la fase más importante para asegurarse de que un error así no se repita. La estrategia a largo plazo debe mezclar controles técnicos y de procesos.

- Configurar

robots.txtcorrectamente: Añade una regla para que los rastreadores no entren en directorios sensibles (Disallow: /backups/). No es una medida de seguridad infalible, pero ayuda a evitar la indexación por accidente. - Políticas de gestión de backups: Establece un protocolo claro que prohíba almacenar copias de seguridad en directorios públicos. Los backups deben guardarse en un entorno seguro y aislado, punto.

- Auditorías periódicas (Escaneos programados): Utiliza los Google Dorks de forma proactiva para auditar tus propios dominios y subdominios en busca de fugas de información. De hecho, los riesgos de subdominios expuestos son un punto ciego muy común que merece atención especial.

- Refuerzo de la seguridad del servidor (Hardening): Asegúrate de que los permisos de los directorios están bien configurados para impedir el listado de archivos por defecto. Para sitios con CMS, aprender a proteger un sistema como WordPress contra ciberataques es un buen punto de partida que cubre la gestión segura de backups.

- Web Application Firewall (WAF): Implementa un WAF para filtrar peticiones maliciosas y detectar patrones de reconocimiento.

- Content Security Policy (CSP): Aunque no previene esta fuga concreta, una CSP robusta mitiga otros vectores de ataque.

Implementar estas medidas de forma consistente transforma la seguridad, pasando de apagar fuegos a construir un sistema realmente resiliente.

Resultados y lecciones aprendidas: el coste de un descuido

El impacto de una brecha de este tipo puede ser devastador:

- Impacto financiero: El coste de la remediación, las posibles multas por incumplimiento de normativas de protección de datos (RGPD) y la pérdida de ventas por la desconfianza de los clientes.

- Impacto reputacional: La confianza de los clientes es difícil de ganar y muy fácil de perder. Una fuga de datos puede dañar la imagen de marca de forma irreparable.

- Lecciones clave: La seguridad no es solo tecnología, sino también procesos y personas. Un simple error humano puede anular las defensas más sofisticadas. La automatización de auditorías y la formación continua son cruciales para minimizar estos riesgos.

Para ayudarte a poner todo esto en práctica, hemos preparado un checklist sencillo que resume las acciones clave para proteger tu infraestructura web.

Checklist de prevención contra Google Hacking

Aquí tienes una tabla que resume las acciones clave para proteger tu infraestructura web y evitar que los motores de búsqueda indexen información sensible.

| Control de seguridad | Descripción de la acción | Nivel de prioridad |

|---|---|---|

Configuración de robots.txt |

Crear y mantener un archivo robots.txt para guiar a los rastreadores lejos de directorios sensibles como /admin o /backups. |

Alta |

| Auditorías con Google Dorks | Realizar búsquedas periódicas usando Google Dorks sobre tus propios dominios para detectar fugas de información antes que los atacantes. | Alta |

| Desactivar listado de directorios | Modificar la configuración del servidor web (ej. Apache, Nginx) para prohibir que se listen los contenidos de los directorios. | Crítica |

| Permisos de archivos restrictivos | Aplicar el principio de mínimo privilegio en los permisos de archivos y directorios para que solo los usuarios autorizados tengan acceso. | Crítica |

| Gestión segura de backups | Almacenar siempre las copias de seguridad en ubicaciones no accesibles públicamente, fuera del directorio raíz de la web. | Crítica |

| Autenticación en zonas sensibles | Proteger directorios administrativos o de gestión con una capa de autenticación HTTP (ej. .htaccess) para limitar el acceso. |

Alta |

| Vigilancia de archivos de log | Asegurarse de que los archivos de log no contengan información sensible y no sean accesibles desde internet. | Media |

Seguir esta lista de control no es una garantía de invulnerabilidad, pero sí eleva enormemente el listón, haciendo que tu web sea un objetivo mucho menos atractivo para quienes buscan explotar la información indexada. La clave, como siempre en seguridad, es la constancia y la proactividad.

Unas cuantas preguntas frecuentes sobre Google Hacking

Para dejar las cosas claras y que te sientas seguro usando esta técnica, vamos a resolver las dudas más comunes sobre la Google Hacking Database. Hablaremos de legalidad, ética y de cómo puedes ponerte a prueba para asegurarte de que entiendes cómo usar esta herramienta para lo que es: fortalecer tu seguridad.

¿Es legal usar la Google Hacking Database?

Sí, usar la Google Hacking Database es totalmente legal. Piénsalo: no estás haciendo nada más que utilizar el buscador de Google para encontrar información que ya está indexada y es pública. No estás forzando ninguna puerta ni explotando una vulnerabilidad para colarte.

Ahora bien, la legalidad se acaba en el mismo instante en que intentas acceder, descargar o modificar cualquier información sensible que encuentres sin tener el permiso explícito del dueño.

La GHDB es como tener un mapa que te señala dónde hay puertas abiertas. Mirar el mapa es legal. Cruzar una de esas puertas sin permiso es allanamiento de morada, con todas las de la ley. Su uso ético se limita, sin excepción, a auditar tus propios sistemas o los de un cliente que te ha dado permiso por escrito.

¿Cómo puedo saber si mi web es vulnerable a Google Hacking?

La forma más directa y eficaz es convertirte en tu propio auditor. No hace falta que te compliques con herramientas raras; solo tienes que pensar como lo haría un atacante y usar los mismos Google Dorks para escanear tu propia web.

Una buena autoauditoría debería seguir estos pasos:

- Acota la búsqueda a tu dominio: Usa siempre el operador

site:tuweb.comcomo base para todas tus búsquedas. - Busca archivos que no deberían estar ahí: Combina lo anterior con

filetype:log,filetype:sql,filetype:bak,ext:configofiletype:env. - Encuentra directorios abiertos: Prueba con

intitle:"index of"para ver si tu servidor está mostrando listados de carpetas que deberían ser privados. - Usa palabras clave comprometedoras: Añade términos como

"password","confidencial","backup"o"database connection"a tus búsquedas.

Si cualquiera de estas búsquedas te devuelve información que no debería ver la luz del día, has encontrado una brecha. El siguiente paso es actuar de inmediato para proteger esa información y pedirle a Google que la desindexe.

¿El archivo robots.txt me protege de esto?

No, para nada. El robots.txt no es una medida de seguridad. Es más bien una guía de buenas maneras para los rastreadores de buscadores que, como Googlebot, deciden hacerle caso. Su función es pedirles amablemente que no indexen ciertas partes de tu web, pero no impide que nadie entre si ya conoce la URL.

Un atacante o un crawler con malas intenciones puede ignorar por completo lo que diga tu robots.txt. Míralo como si fuera un cartel de "No pasar" puesto en un camino abierto: la gente educada dará la vuelta, pero quien quiera entrar, lo hará sin pensárselo dos veces.

La protección de verdad, la que funciona, siempre se aplica a nivel de servidor. Esto significa:

- Configurar bien los permisos: Asegurarte de que los archivos y directorios solo son accesibles para quien debe.

- Usar autenticación: Proteger las carpetas importantes con usuario y contraseña.

- Desactivar el listado de directorios: Impedir que el servidor muestre el contenido de las carpetas como si fuera el explorador de archivos.

- Eliminar lo que sobre: Borrar cualquier dato sensible de las carpetas públicas.

Usar un robots.txt es una buena práctica y una primera capa de defensa, pero nunca, jamás, debe ser tu única protección.

En DragonSec, sabemos que la única forma de ir por delante de las amenazas es ser proactivo. Nuestra plataforma te ayuda a monitorizar tu superficie de ataque sin descanso, descubriendo configuraciones erróneas y exposiciones críticas antes de que alguien más lo haga.

Solicita un scan de vulnerabilidades gratuito y descubre tu nivel de exposición